12月11日面壁智能宣布公司完成新一轮数亿元融资,本轮融资后,面壁智能将进一步提速以端侧AI为代表的高效大模型商业化布局,面壁智能CEO李大海表示,更高知识密度的小模型和端侧智能,成为大模型发展的新阶段。如今,因为端侧智能发展的深刻影响,主流消费电子和新兴硬件正演变成一个个在不同场景、执行特定任务的超级智能体,成为新一轮科技创业大风口。

随着AI PC和AI手机的推出以及Apple Intelligence等产品不断改进,以及其他在小型语言模型上运行的应用程序正在形成,一部分AI查询会在边缘或设备上进行处理,Barclays最新的一篇AI推理计算的未来发展趋势报告指出,边缘查询从2024年总查询的1%上升到2025年的10%。估计到2026年,将有15%的查询在终端设备上进行,到2028年约为25%,一些专家估计,未来端侧AI的占比预计会增长至50%。

随着大模型能力持续增强,应用场景持续突破,大模型应用架构也逐渐清晰,其中在应用层中agent成为业内关注的焦点,智能体是大模型能力的扩展,弥补大模型在操作和执行方面的不足,具备记忆、搜索、规划、决策、执行等能力。

Barclays的最新报告认为,目前AI行业发展的处于Chatbot及Copilot时代,2025—2026年即将迎来agent时代。12月11日谷歌发布最新模型Gemini 2.0的同时推出了一系列agent,智能体正成为大模型的下一站。

端侧大模型和智能体正成为AI的新阶段,未来AI算力需求或将迎来新变化。Barclays的最新报告认为推理计算将逐渐主导AI算力需求。随着像GPT-5这样的大型语言模型和新的AI基础设施(如NVIDIA Blackwell GPU)的出现,AI应用,尤其是agent系统,将迎来爆发式增长,消费者和企业人工智能市场可能会真正开始腾飞。

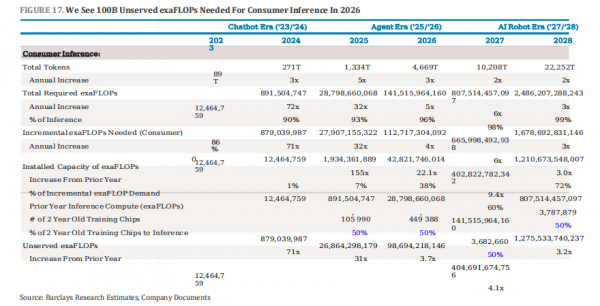

报告预测,随着agent系统推出,很大一部分计算可能会转移到对这些服务的推理上,约占推理市场的30%。随着采用的增加,整体推理可能会超过训练计算,报告预测,到2026年,如果消费者AI采用率超过10亿DAU,agent在企业任务渗透率超过5%,那么所需的总计算量约为1500亿EFLOPs,其中推理计算将占近75%,训练计算占25%。

基于企业级agent的采用估计,企业推理需求的计算量在2026年约为50亿EFLOPs,随着B200从明年开始安装,H100应该用于企业推理,报告估计只有未满足的30亿EFLOPs企业推理需求需要在2026年使用新芯片。

企业推理需求的计算量在2026年约为 50亿EFLOPs

NVIDIA GPU目前占据推理市场约80%的份额,但到2028年这一比例将下降至约50%,主要原因是最大型的超大规模云服务商都在定制构建定制ASIC(亚马逊的Inferentia、Meta的MTIA、谷歌TPU v6、Grok和其他),报告预测ASIC芯片市场份额将持续增长,到2028年,这些ASIC可以处理高达40%的消费者推理计算。

定制ASIC芯片上推理工作负载比例的增加,预计将进一步降低每token的单位成本,推理单元成本(每百万tokens)正以每18个月超过90%的速率持续下降。不过,报告指出,单位成本的降低并没有导致产能过剩,而是带来了更多的使用,刺激了更多AI产品的开发和应用,从而增加了对算力的总需求。

定制ASIC芯片上推理工作负载比例的增加

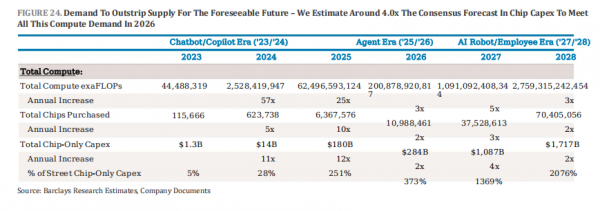

此外,市场对算力相关资本支出的估计过低,Barclays的半导体研究团队预测,到2026年,仅AI芯片相关的资本支出就需要近3000亿美元,这比市场共识预测高出370%以上,如果将其他计算和数据中心资产的资本支出考虑在内,总资本支出可能高达7000亿美元。

到 2026 年,仅 AI 芯片相关的资本支出就需要近 3000 亿美元

端侧大模型算力需求方面,报告认为,虽然端侧AI可以处理一部分AI查询,但占比相对较小,由于设备的算力、内存和功耗限制,大型语言模型难以在端侧有效运行,云端数据中心仍将是满足AI算力需求的主力军。

© 版权声明

本文的所有权归原作者所有,未经授权禁止转载和复制。如您侵犯了您的权益,请及时联系我们,本站将立即删除。谢谢您的理解与支持。

相关文章

暂无评论...